阿里巴巴推出OutfitAnyone:支持任何服装与任何人的高质量虚拟试穿

摘要

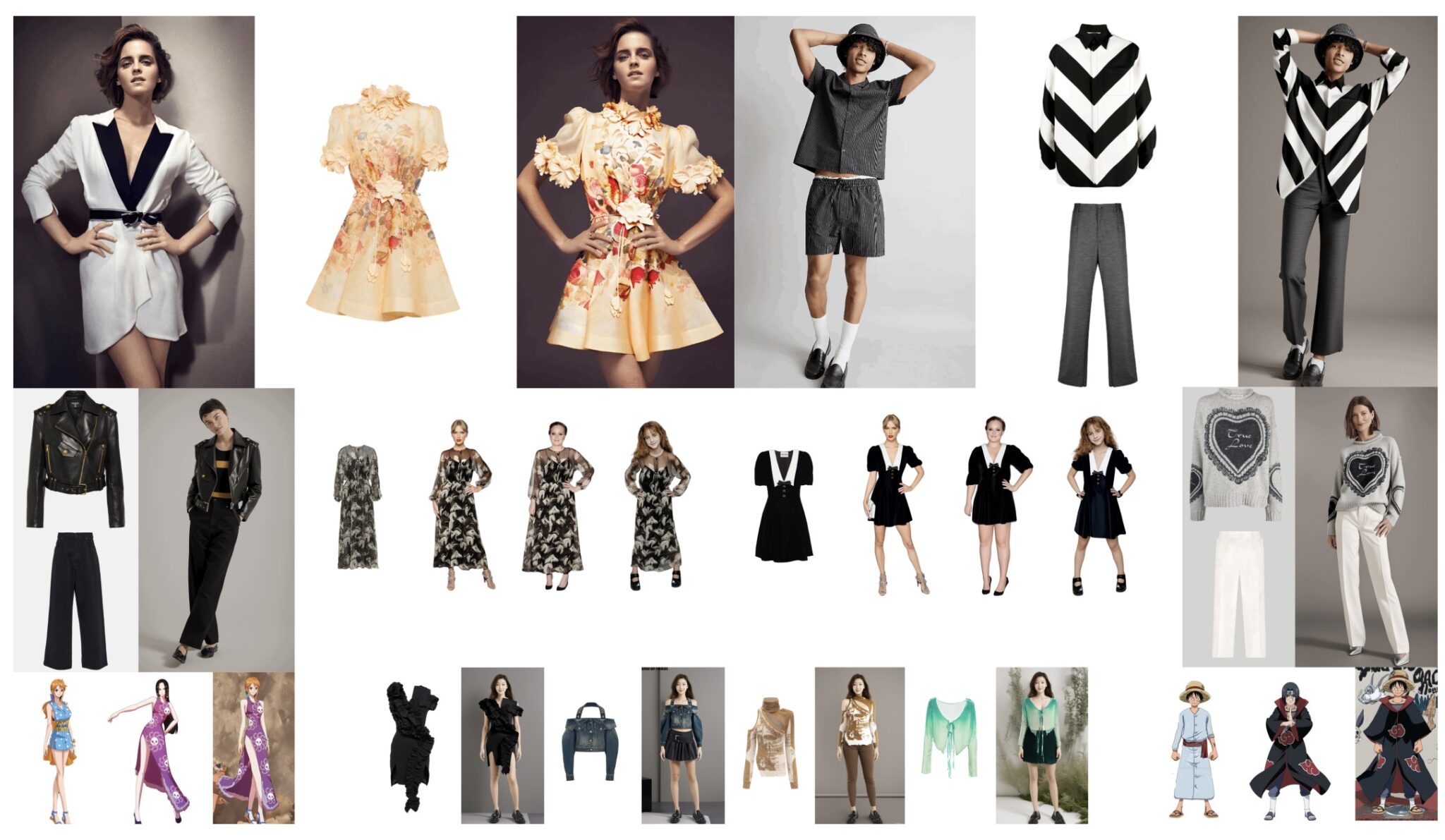

OutfitAnyone是阿里巴巴开发的一款基于扩散模型的2D虚拟试穿框架,旨在解决现有虚拟试穿技术在生成高保真、细节一致的结果时遇到的挑战。OutfitAnyone采用双流条件扩散模型,可以处理衣物变形,生成更加逼真的试穿效果。无论是不同的姿势、体型,还是从动漫到野外的广泛应用场景,OutfitAnyone都能适应并生成高质量的试穿效果。

主要特点

- 高保真度虚拟试穿:利用双流条件扩散模型,保持衣物的纹理、图案和形状一致。

- 多样化适用人群:适用于不同年龄、性别和肤色的人群,甚至可以生成动漫人物的虚拟试穿效果。

- 广泛的衣物支持:支持单件衣物和多件衣物的试穿,包括上装和下装的组合。

- 灵活的体型和姿势适应:通过姿势和体型指导,能适应不同的体型和姿势变化,生成逼真的穿衣效果。

- 背景和光照保留:在复杂的背景和光照条件下生成合理的试穿效果。

- 高质量图像生成:支持从384 x 684到1080 x 1920的灵活图像尺寸生成。

- 时装设计辅助:帮助时装设计师生成独特和流行的服装设计,并提供创意灵感。

技术方法

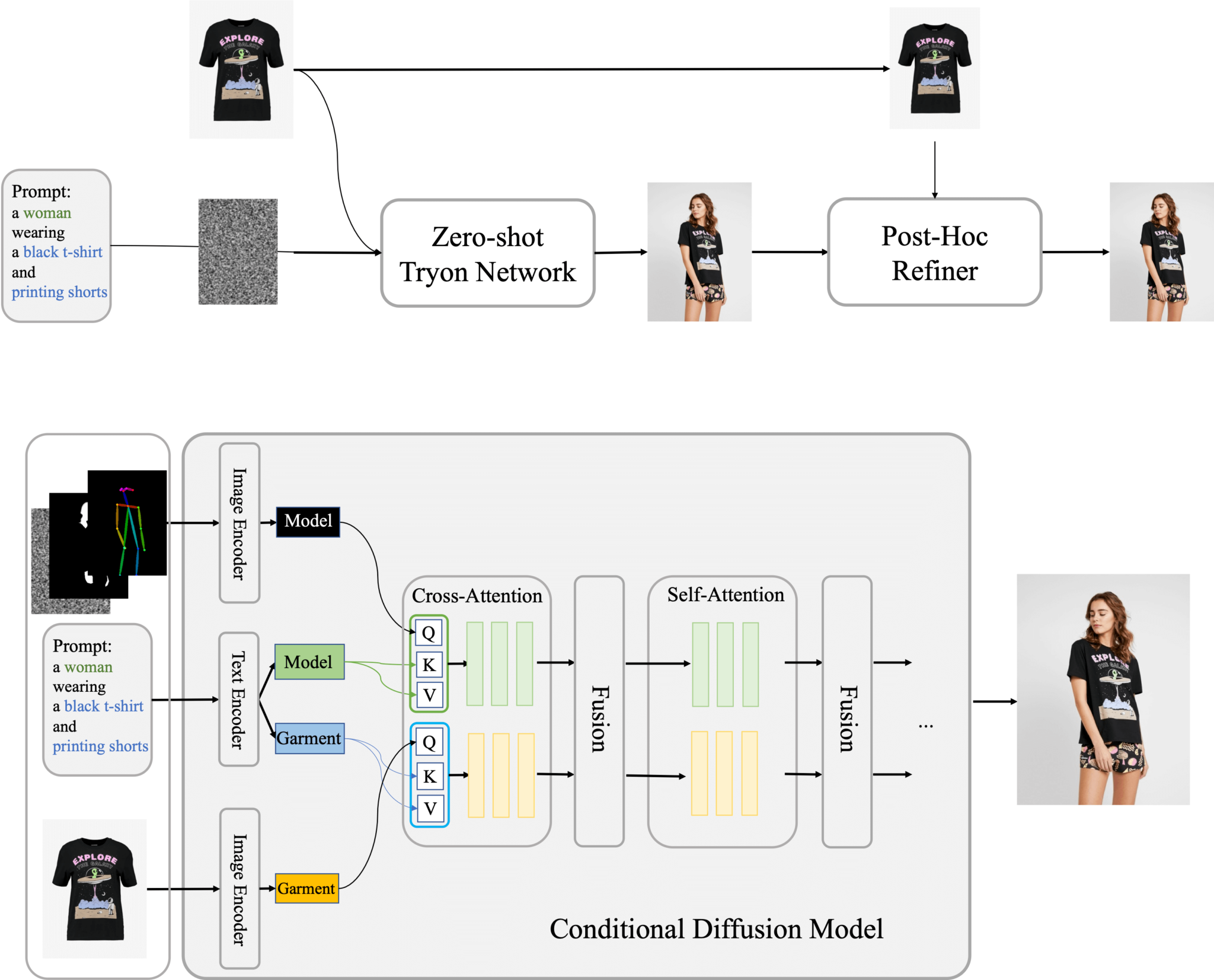

- 双流条件扩散模型:独立处理人体数据和衣物数据,并在融合网络中合并,生成最终试穿图像。

- 衣物特征注入:通过稳定扩散和ReferenceNet注入衣物特征,提升生成图像的质量。

- 无分类器指导:通过无条件分类器指导生成更精确、一致的结果。

- 背景和光照保留:保持生成图像与原始图像在背景和光照上的一致性。

- 姿势和体型指导:利用骨骼图像、密集姿势图像或SMPL模型图像实现姿势控制。

- 细节修饰器:通过构建高低质量图像对,训练扩散模型恢复细节。

应用场景

- 个人肖像创作

- 广告设计

- 电影特效制作

- 虚拟人物塑造

相关链接

项目及演示:https://humanaigc.github.io/outfit-anyone/

论文:https://arxiv.org/pdf/2407.16224

© 版权声明

文章版权归作者所有,未经允许请勿转载。