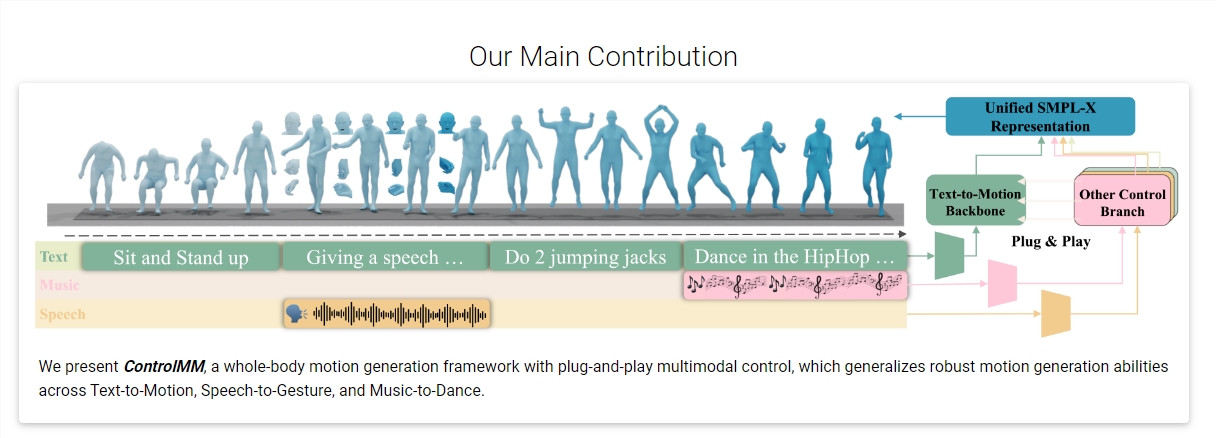

ControlMM:多模态输入生成全身动作的创新技术框架

摘要

香港中文大学和腾讯联合推出了ControlMM,一个革命性的技术框架,能够通过文字、语音和音乐等多种模态输入生成全身动作。ControlMM 通过先进的算法,解决了多模态运动生成中的诸多挑战,提供了一个高效、统一且具有高度适应性的解决方案。

主要特点

- 🌐 多模态控制:支持文本、语音和音乐等多种输入方式,增强了控制能力和适应性。

- 🛠️ 统一框架:采用统一的ControlMM框架,整合多种运动生成任务,提高生成效率。

- 🔍 分阶段训练策略:通过粗到细的训练策略,优化模型在不同条件下的表现。

- 🎯 高效的运动知识学习:ControlMM-Attn模块优化运动序列表示,提升准确性。

- 📈 新基准引入:ControlMM-Bench,首个基于统一SMPL-X格式的多模态全身运动生成基准。

技术优势

- 🚀 显著的性能提升:在Text-to-Motion、Speech-to-Gesture和Music-to-Dance等方面展现领先性能。

- 💎 可控性、连续性和运动合理性:与基线模型相比,ControlMM在这些方面具有显著优势。

应用场景

- 🎭 动画和电影制作:为角色生成逼真的全身动作。

- 🎮 游戏开发:快速生成游戏角色动作。

- 🎵 音乐舞蹈创作:根据音乐创作舞蹈动作。

相关链接

© 版权声明

文章版权归作者所有,未经允许请勿转载。